Spark/Scala/PySpark 설치

JDK on Windows

First, make sure you have the Java 8 JDK (or Java 11 JDK) installed. https://ynebula.github.io/posts/java/java8_install_on_ubuntu/ Path에 빈 칸이 없어야 한다. 그래서 C:\Java 로 설치한다. => 이거 다시 테스트 해봐야 함… 프로그램 파일 밑에 설치

Install Spark

on Windows

- Spark 사이트(https://spark.apache.org/downloads.html)에서 바이너리 파일 다운로드

- C루트 디렉토리에 설치

- 환경변수에 SPARK_HOME 등록

on Mac

- Package 확인: brew search spark

- 설치: brew install apache-spark

- 확인: brew list |grep scala

- 환경변수 SPARK_HOME 및 Path 설정

Spark Test

- spark-shell: scala언어를 REPL환경에서 수행

- pyspark을 사용해 python언어를 REPL 환경에서 수행

- spark-submit: spark-submit은 클러스터에서 application을 수행

Setup Scala using IntellJ IDE

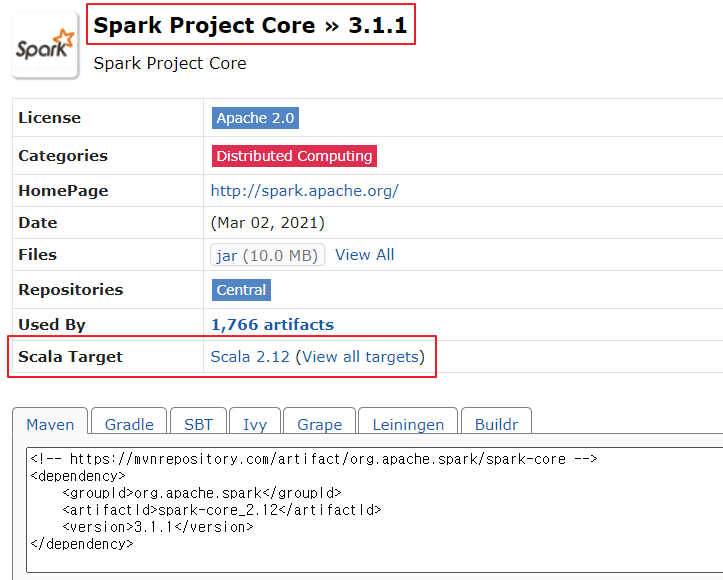

주의점) Scala와 Spark 버전을 맞춰야 빌드됨 다음 메이븐 사이트에서 버전 확인할 수 있음

https://mvnrepository.com/artifact/org.apache.spark/spark-core_2.12/3.1.1

on Windows

- Scala 사이트(https://www.scala-lang.org/download/)에서 바이너리 파일 다운로드

- C루트 디렉토리에 설치

- 환경변수에 SCALA_HOME 등록

on Mac

- Package 확인: brew search scala

- 설치: brew install scala

- 확인: brew list |grep scala

- 환경변수 SCALA_HOME 및 Path 설정

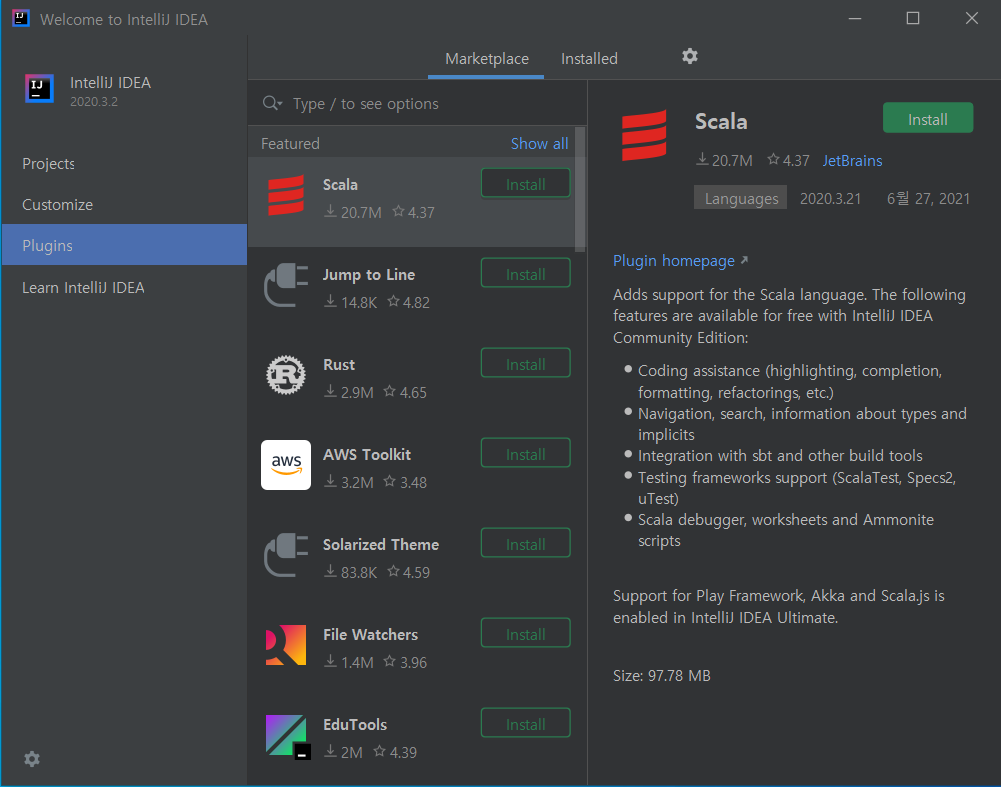

Setup Scala Plugin on IntellJ IDE

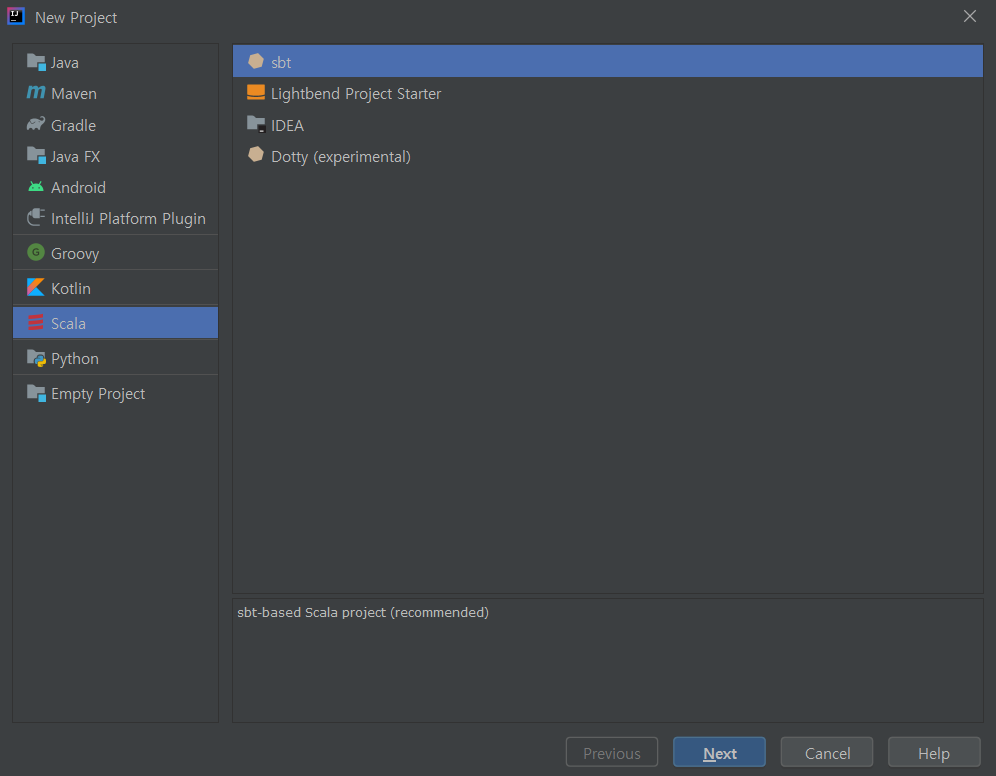

WordCount Project

- Create New Project

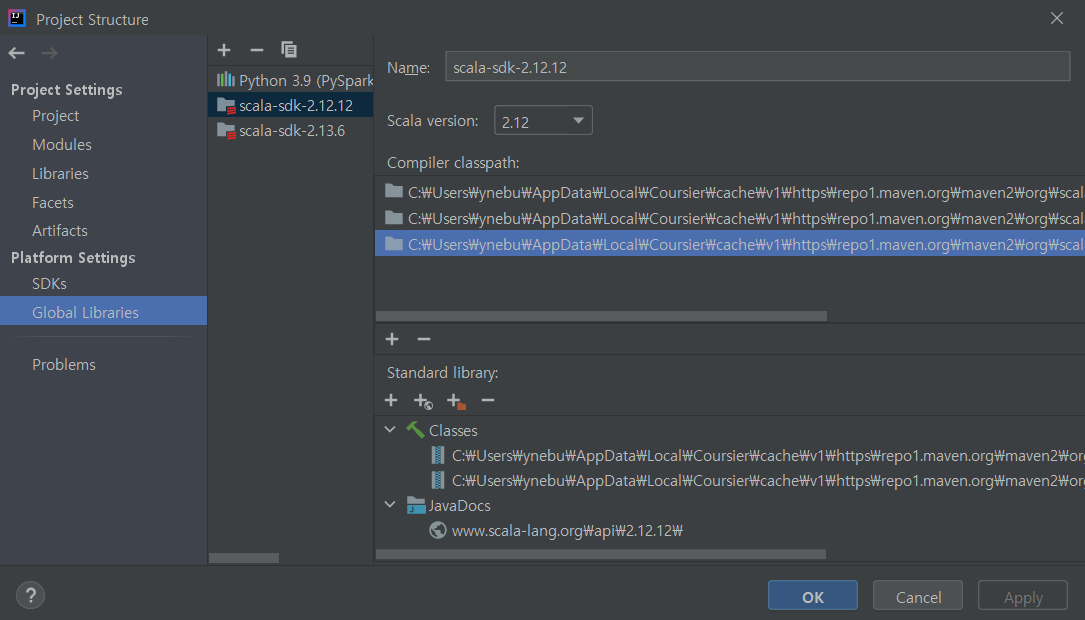

- Projecgt Structure

- Sync build.sbt

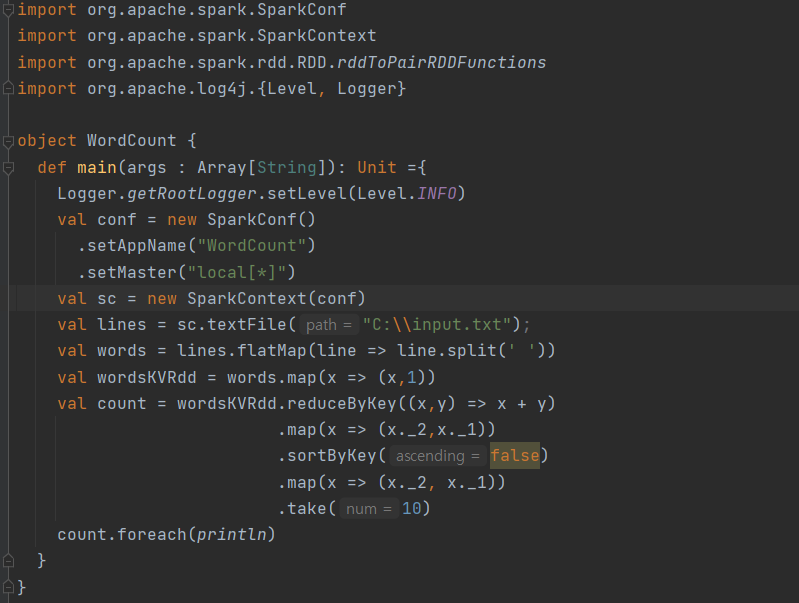

name := “ScalaTest” version := “0.1” scalaVersion := “2.12.12” libraryDependencies ++= Seq( “org.apache.spark” % “spark-core_2.12” % “3.1.2”) - Source Code

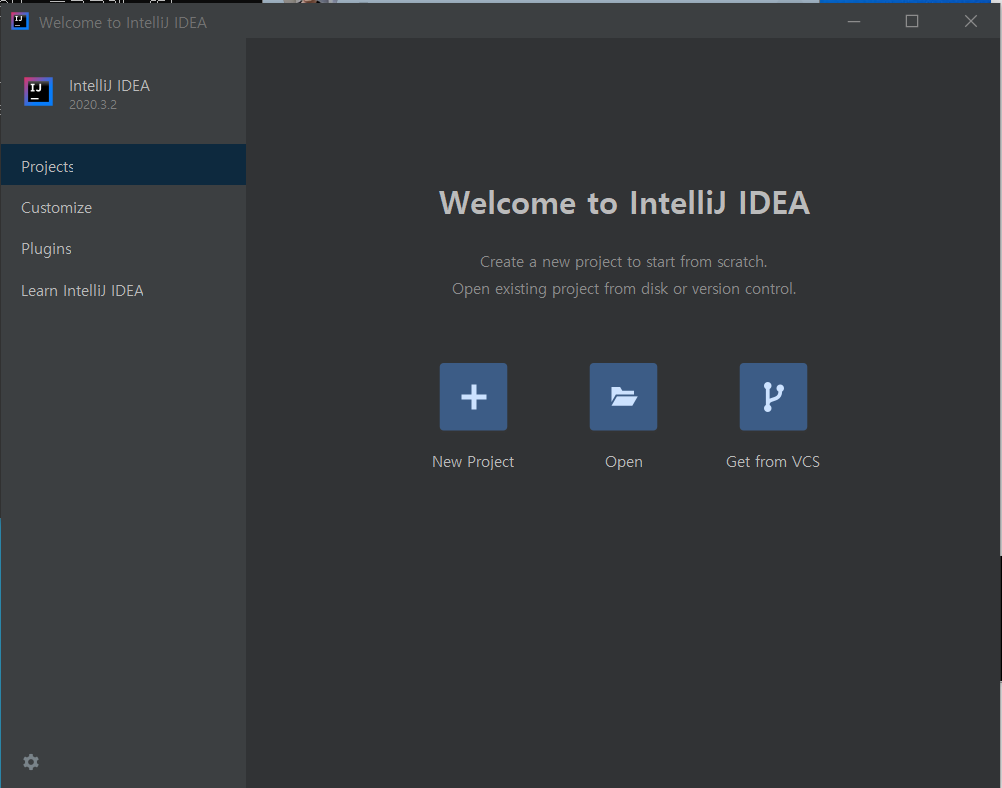

Setup PySpark using IntellJ IDE

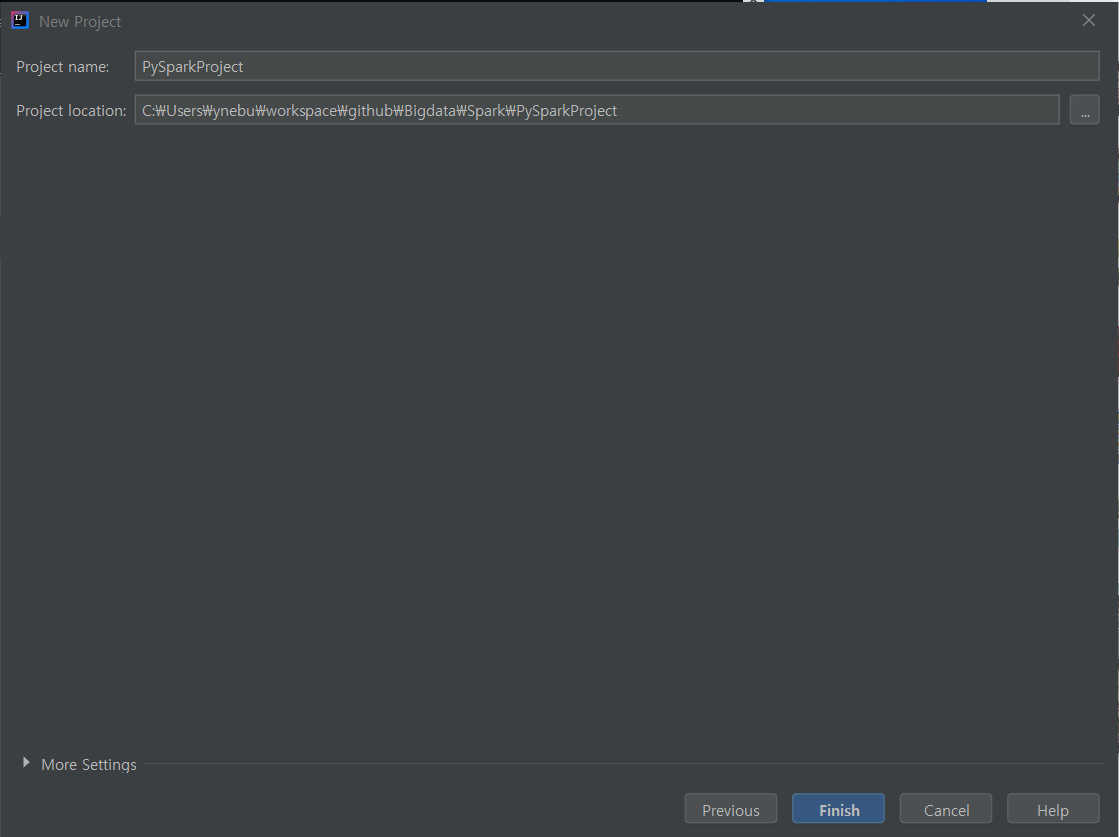

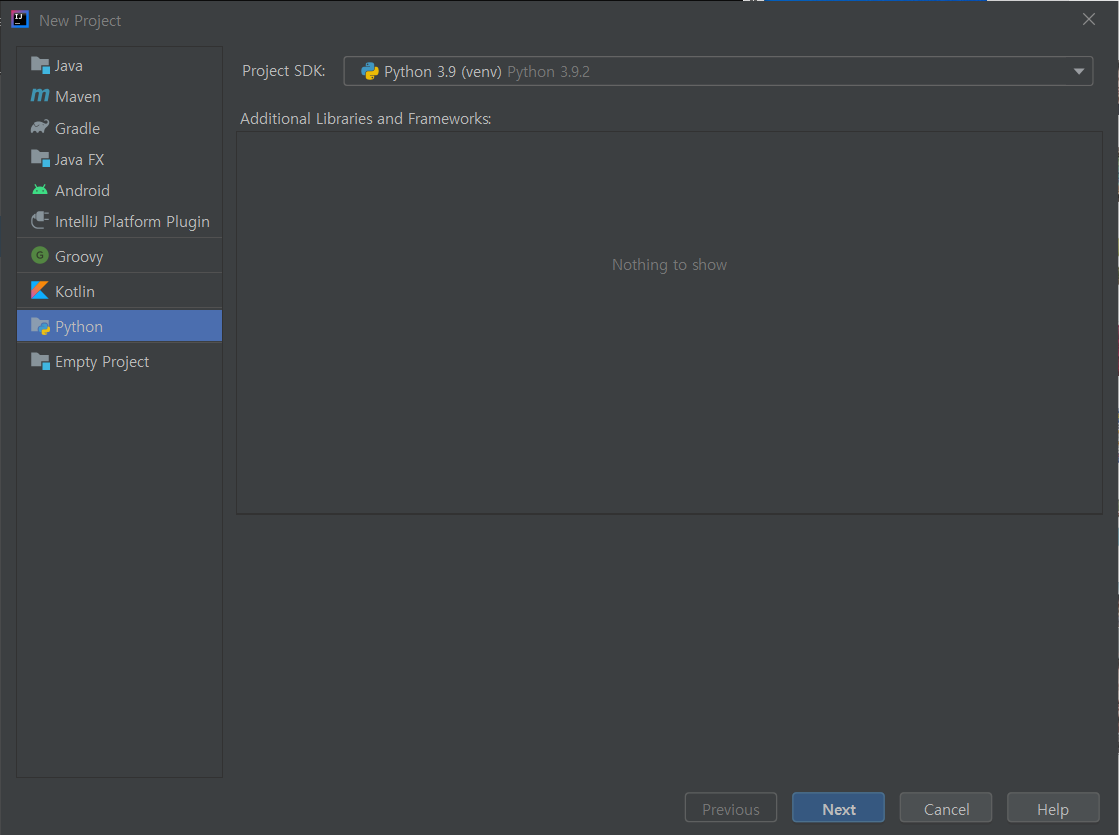

빈 프로젝트 생성

Project SDK 설정 - Python Plugin 설치

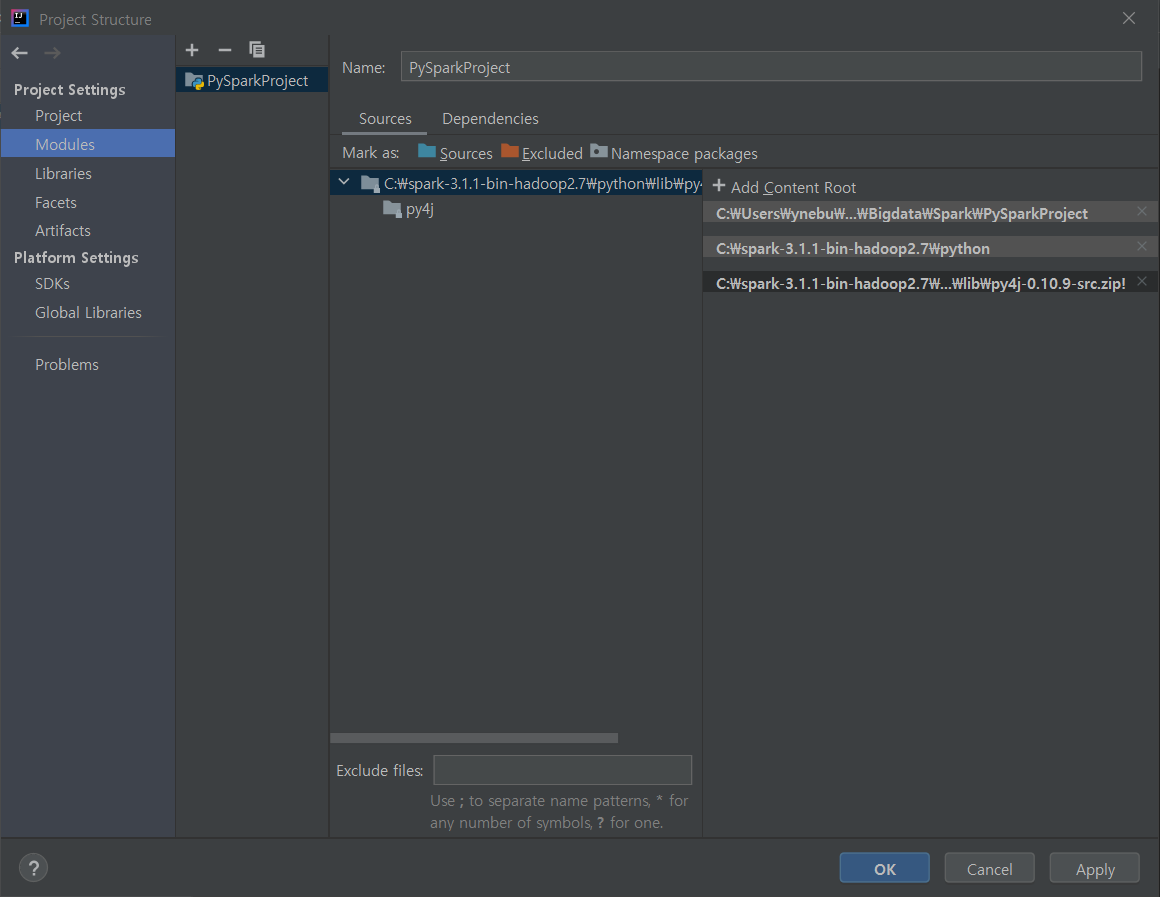

PySpark LIB Import

다음 화면에 접근해서 PySpark Lib를 추가

화면 접근: Project Structure - Module - Add

Import PySpark

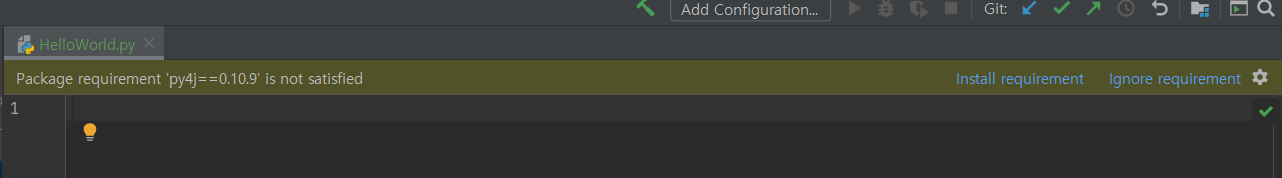

Import py4j

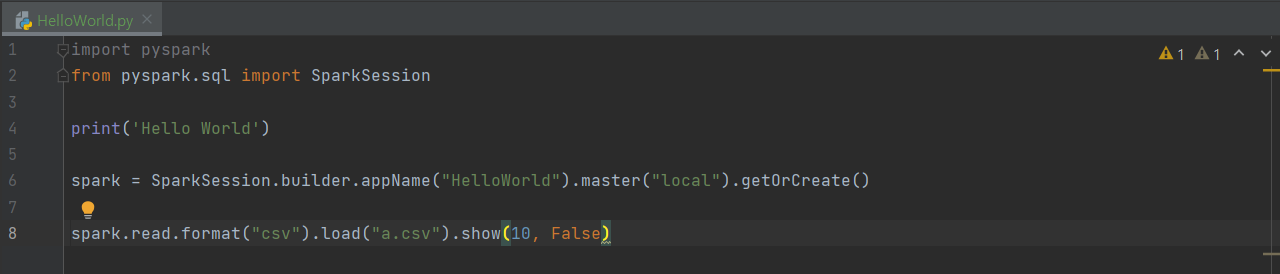

다음 소스를 구현해서 PySpark을 수행합니다.